Introduction

Vous êtes développeur, passionné d’IA ou simplement curieux de tester des modèles de langage ? Ollama, un outil open source, vous permet d’exécuter des modèles d’IA comme LLaMA, Mistral ou Qwen localement, sans dépendre d’une connexion internet. Dans cet article, je vous explique comment l’utiliser, ses avantages et ses cas d’usage.

Qu’est-ce que Ollama ?

Ollama est un serveur local qui simplifie l’installation et l’utilisation de modèles d’IA de grande taille (LLM). Il s’agit d’une alternative à des plateformes comme Hugging Face ou AWS, mais en mode décentralisé.

Pourquoi est-ce utile ?

- Privé : Aucune donnée n’est envoyée en ligne.

- Rapide : L’exécution locale évite les latences.

- Personnalisable : Vous pouvez entraîner ou adapter des modèles.

Pourquoi Ollama ?

Voici pourquoi ce tool est devenu incontournable :

1. Facilité d’utilisation

- Installation simple via un CLI (command line interface).

- Compatibilité avec des outils comme Docker, Python, ou des API REST.

2. Modèles prêts à l’emploi

- Vous pouvez charger des modèles comme

llama2,mistral, ouqwendirectement. - Exemple :

ollama run llama2pour lancer le modèle.

3. Développement local

- Idéal pour tester des applications (chatbots, génération de texte, etc.) sans dépendre de services externes.

4. Écosystème actif

- Une communauté de développeurs contribue à des modèles personnalisés et des outils complémentaires.

Comment l’installer ?

Voici les étapes pour lancer Ollama sur votre machine :

1. Téléchargez Ollama

- Windows : https://ollama.com/download

- macOS/Linux : Utilisez

curlouwgetpour installer via le terminal.

2. Exécutez le serveur

ollama serveCela démarre le serveur sur votre machine.

3. Chargez un modèle

ollama pull llama2Ensuite, utilisez ollama run llama2 pour interagir avec le modèle.

4. Intégrez-le à vos projets

- Utilisez les API REST pour connecter Ollama à votre application.

- Exemple :

curl http://localhost:11434/api/generate -d '{"model": "llama2", "prompt": "Bonjour, comment ça va ?"}'

Cas d’usage pour les développeurs

- Chatbots personnalisés : Créez des assistants IA pour vos applications.

- Génération de texte : Testez des scénarios de rédaction d’articles, de scripts, ou de code.

- Analyse de données : Utilisez les modèles pour interpréter des données complexes.

- Entraînement local : Adaptez des modèles à des domaines spécifiques (ex. médical, juridique).

Conclusion

Ollama est un outil puissant pour les développeurs et les passionnés d’IA. En le déployant localement, vous gagnez en contrôle, en sécurité et en flexibilité. Quel que soit votre projet (application, recherche, ou simplement pour tester), Ollama mérite d’être exploré.

Vous avez déjà utilisé Ollama ? Partagez vos expériences en commentaire !

Mots-clés SEO

- Ollama

- Modèle d’IA local

- LLaMA

- Développement IA

- Chatbot

- Génération de texte

Discalmer

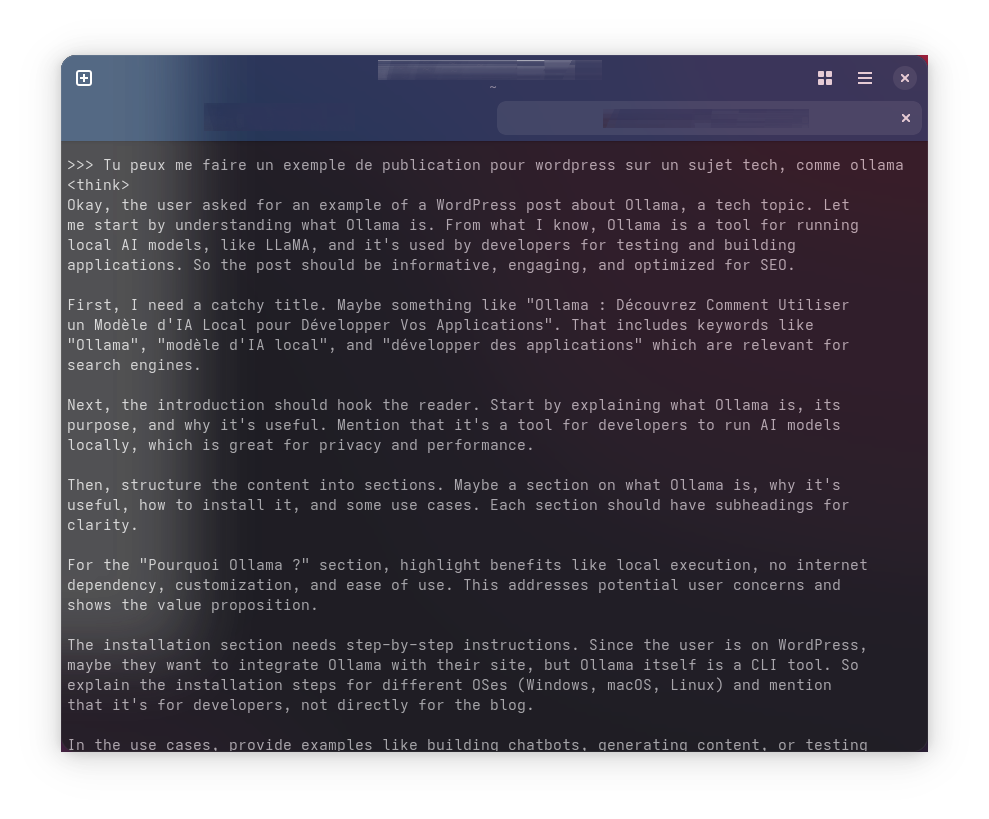

Cet article à été généré par qwen3:30b sur ollama 0.6.7